يشاهد مستخدمو الإنترنت آلاف من مقاطع الفيديو يوميا على المنصات المختلفة، ويشاركون ويتفاعلون مع أغلبها، وكلما كان الفيديو مثيرا للجدل ويضم مشاهير وسياسيين كلما نال شعبية أكبر، ولكن هل شككت ولو مرة فى مدى صحة الفيديو الذى تشاهده؟، هذا السؤال لم يكن منطقيا منذ سنوات قليلة، لأن تزيف الفيديوهات كان أمر صعب للغاية ويمكن كشفع بسهولة، ولكن الآن لدى العالم ما يعرف بالذكاء الاصطناعى وتعليم الآلة والذى ترتب عليه ظهور برامج تحمل اسم الـ deepfake، وتلك البرامج مهمتها خداعك وإقناعك بأن هناك نجم أو سياسى يقول أو يفعل أشياء لم يقم بها فى الواقع، وفيما يلى نرصد لك أمورا قد تعرفها لأول مرة عن تلك التقنية الجديدة التى تهدد مشاهير العالم.

ما هى تقنية الـ deepfake

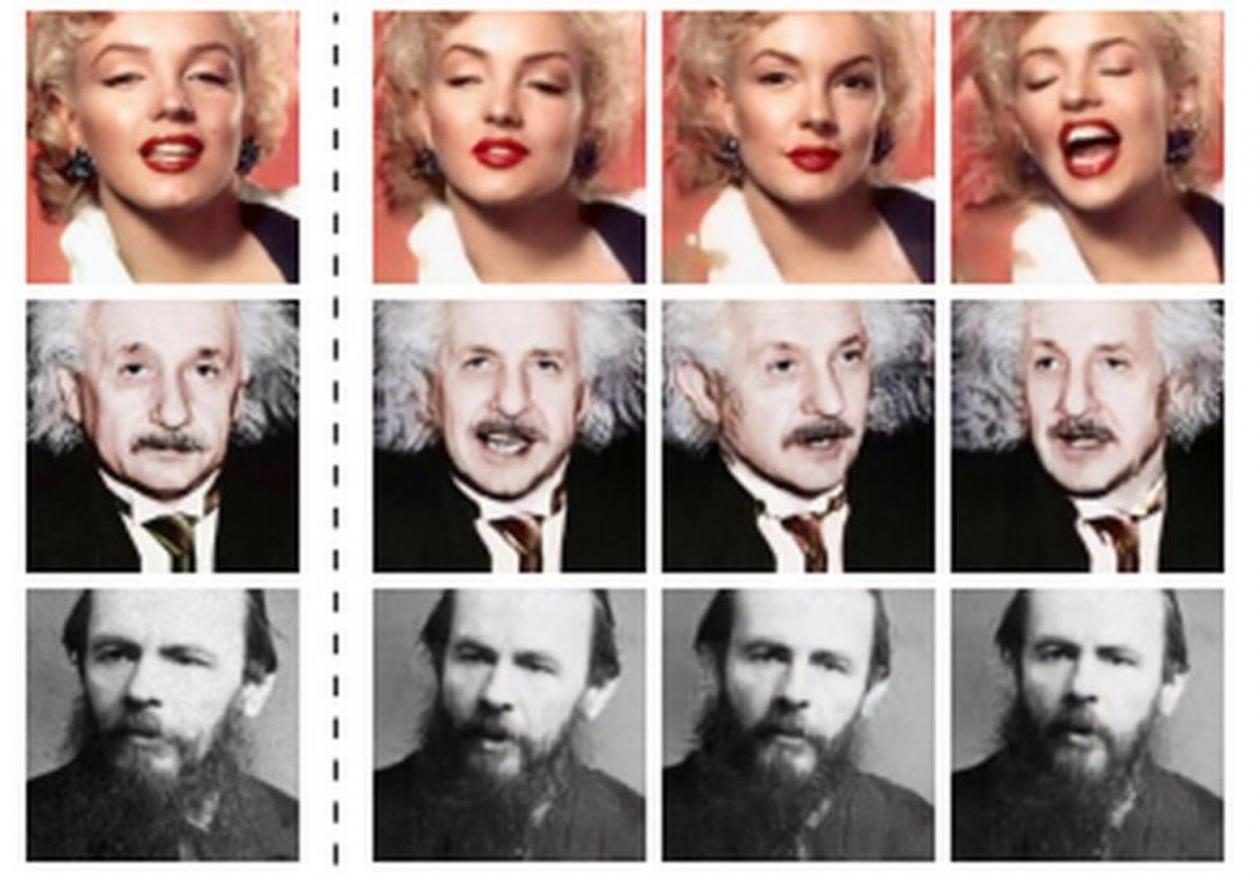

؟Deepfakes هى مقاطع فيديو مزيفة أو تسجيلات صوتية تبدو تمامًا مثل الحقيقية، ويمكن لأى شخص اليوم تحميل برامج الـ deepfake وإنشاء مقاطع فيديو وهمية مقنعة فى أوقات فراغهم.

deepfake

وحتى الآن، اقتصر استخدام تلك التقنية على الهواة الذين يضعون وجوه المشاهير على أجساد نجوم الاباحية ويجعلون السياسيين يقولون أشياء مضحكة، ومع ذلك ، سيكون من السهل بنفس القدر إنشاء مجموعة من التنبيهات الطارئة تحذيرًا بحدوث هجوم وشيك أو تدمير زواج شخص ما من خلال مقطع فيديو جنسى مزيف أو تعطيل انتخابات قريبة بنشر مقطع فيديو مزيف أو تسجيل صوتى لأحد المرشحين قبل أيام من بدء التصويت.

ما مدى خطورة deepfakes

؟تقنية الـ deepfakes تجعل الكثير من الناس يشعرون بالتوتر، لدرجة أن ماركو روبيو ، السيناتور الجمهورى عن فلوريدا والمرشح الرئاسى لعام 2016 ، أطلق عليهم اسم المكافئ الحديث للأسلحة النووية.

وقال قبل أسبوعين ، "إذا أردت فى الماضى تهديد الولايات المتحدة، فأنت بحاجة إلى 10 حاملات طائرات، وأسلحة نووية، وصواريخ بعيدة المدى، لكن اليوم ، تحتاج فقط إلى الوصول إلى نظام الإنترنت الخاص بنا ونظامنا المصرفى وشبكة الكهرباء والبنية التحتية، وفى المستقبل سيكون كل ما تحتاج إليه هو القدرة على إنتاج فيديو مزيف واقعى جدًا يمكن أن يقوض انتخاباتنا، مما قد يؤدى ببلادنا إلى أزمة هائلة داخليًا ويضعفنا بعمق ".

جانب من التزيف

ويقول تيم هوانج ، مدير مبادرة الأخلاقيات والحوكمة فى مركز "بيركمان كلاين" ومختبر MIT Media ، لـ CSO: "لا تقل خطورة الـ deepfakes عن القنابل النووية؟".

كيف تعمل الـ deepfakes

؟هناك حقيقة تقول إن البشر يبحثون عن معلومات تدعم ما يريدون تصديقه وتجاهل الباقي، وتقنيات مثل deepfakes تمنح الجهات الخبيثة الكثير من القوة، لذلك نرى انتشار واسع للأخبار المزيفة، التى تنتشر تحت ستار الحقيقة.

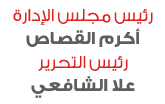

وتستغل تقنية الـ Deepfakes هذا الاتجاه الإنسانى باستخدام شبكات تحمل اسم (GANs)، حيث يقوم نموذجان للتعلم الآلى (ML) بتثبيتهما، ويقوم نموذج ML بالتدريب على مجموعة بيانات ثم يقوم بإنشاء فيديو مزيف، بشكل يعجز حتى نموذج ML آخر عن الكشف عنه.

التقنية الجديدة

وكلما كبرت مجموعة بيانات التدريب، أصبح من السهل على المزور إنشاء فيديوهات يمكن تصديقها، هذا هو السبب فى استخدام مقاطع الفيديو الخاصة بالرؤساء السابقين ومشاهير هوليوود بشكل متكرر، إذ هناك الكثير من مقاطع الفيديو المتاحة لتدريب الذكاء الاصطناعى.

الفيديوهات مثيرة للجدل

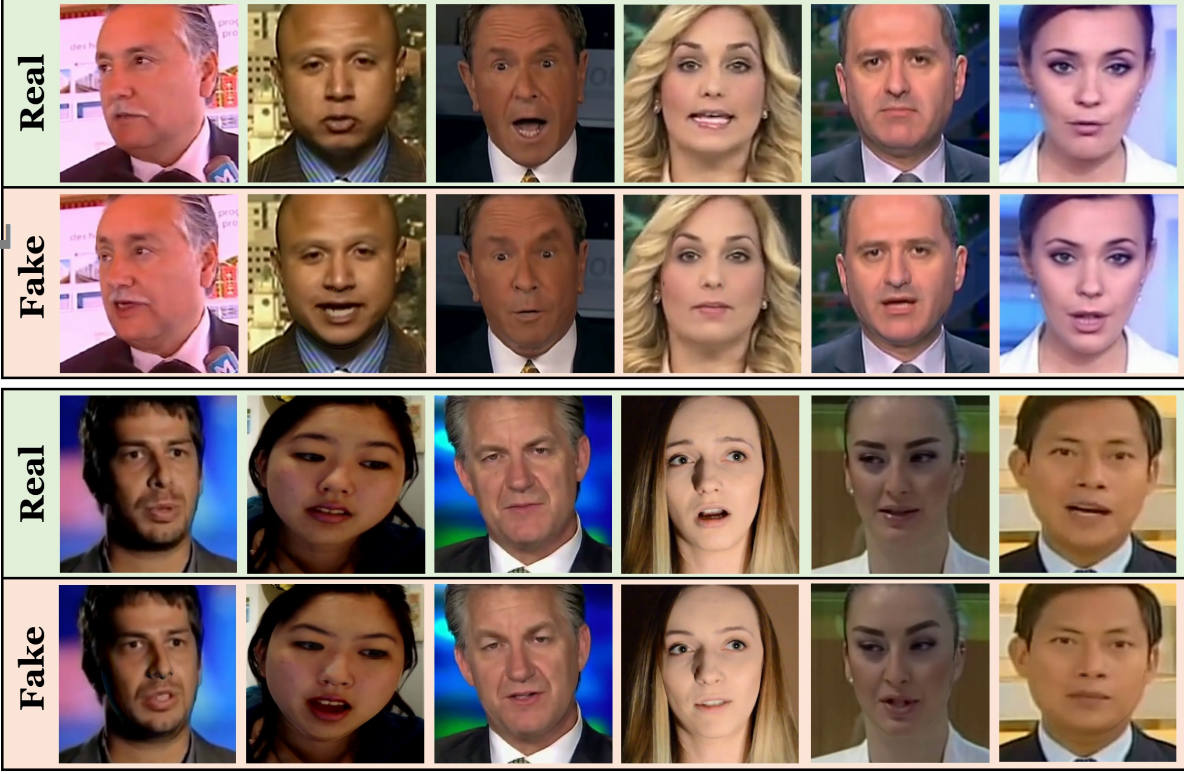

اتضح أن مقاطع الفيديو منخفضة التكنولوجيا يمكن أن تكون شكل من أشكال التضليل ايضا، مثل الجدل الدائر حول الفيديو الذى تم تعديله ليظهر وكأن هناك مواجهة بين الرئيس ترامب مع مراسل CNN جيم أكوستا فى مؤتمر صحفى فى نوفمبر الماضى.

إذ يظهر الفيديو بوضوح امرأة تحاول أخذ الميكروفون من أكوستا، لكن التعديل اللاحق جعلها تبدو وكأنها مراسلة CNN هاجمته.

تقنيات deepfake

يؤكد هذا الحادث على المخاوف من إمكانية التلاعب بالفيديو بسهولة لتشويه شخص معين، سواء مراسل أوسياسى أورجال أعمال أوعلامة تجارية. وعلى عكس ما يسمى بـ "deepfakes"، الفيديوهات ذات التقنية المنخفضة قريبة جدًا من الواقع إلى درجة أنها تمزج الخط الفاصل بين الصواب والخطأ.

كيفية اكتشاف مقاطع الـ deepfakes

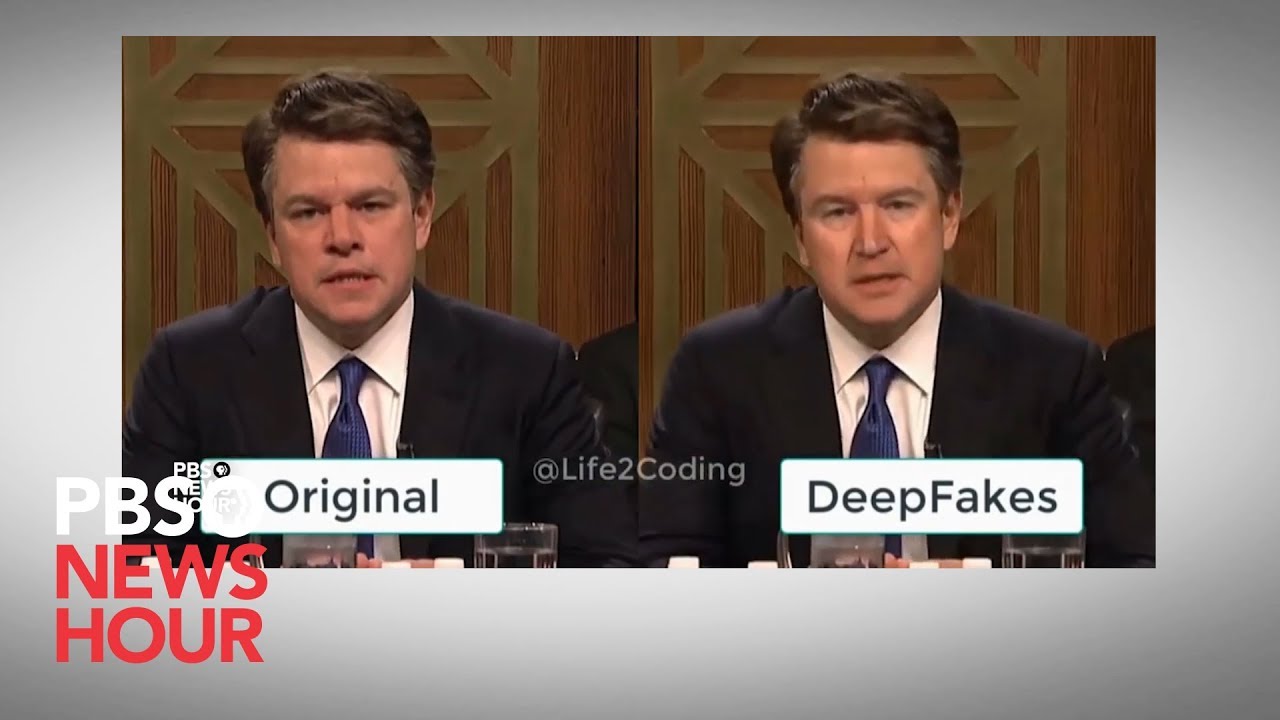

؟اكتشاف deepfakes صعب، ولكن يمكن اكتشاف الزيف من خلال بعض العلامات التى تلاحظها الآلات، مثل عدم وجود وميض للعين أو الظلال التى تبدو خاطئة. ولكن تتحسن شبكات GAN التى تنتج تلك الفيديوهات طوال الوقت وسنضطر قريبًا إلى الاعتماد على فرق متخصصة وتقنيات عالية لاكتشاف زيف الفيديوهات.

وهذه مشكلة صعبة للغاية حيث تقوم وكالة الدفاع الأمريكية DARPA بإنفاق الأموال على الباحثين لإيجاد طرق أفضل لمصادقة الفيديو، ومع ذلك ، نظرًا لأن GANs يمكن تدريبها على تعلم كيفية تجنب مثل هذه الأشياء التى تساعد فى كشف الزيف، فليس من الواضح أن هذه معركة يمكن للبشر الفوز بها.

دقة الفيديوهات المزيفة

وقال David Gunning ، مدير برنامج DARPA المسؤول عن المشروع ، لـ MIT Technology Review: "من الناحية النظرية ، إذا أعطيت GAN كل التقنيات التى نعرفها لكشفها، فبإمكانها اجتياز كل هذه التقنيات".

وإذا لم نتمكن من اكتشاف مقاطع الفيديو مزيفة، فقد نضطر قريبًا إلى عدم الثقة فى كل ما نراه ونسمعه.

المواد الإباحية المزيفة وتهديدها للمشاهير

التهديد الأكثر واقعية يتمثل فى إنتاج مواد إباحية مزيفة عميقة تضع رأسًا مشهورًا على هيئة نجم إباحي.

وهو أمر يشبه الانتقام الجنسى، ولكن دون أن يقوم الشخص المعنى بأى فعل إباحى، وكل ما يحتاج إليه الشخص المزيف هى مجموعة من صور الضحية، مأخوذة بسهولة من وسائل التواصل الاجتماعى لهذا الشخص، وفيديو لوجه الضحية طوله عدة دقائق.

deepfake-trump

حتى المشاهير عبروا عن رعبهم عندما وجدوا رؤوسهم على جسم نجم إباحى فى مقطع فيديو منتشر على كافى المواقع.

كيف يتم التصدى لتلك التقنية؟

يمكن التصدى من خلال القانون، مثل قانون الملكية الفكرية، وقانون الخصوصية، بالإضافة إلى قوانين الإباحية الجديدة التى سنتها العديد من الولايات فى الولايات المتحدة مؤخرًا.

وفى العديد من الحالات، قامت المنصات، مثل Gfycat و Pornhub، بإزالة مقاطع الفيديو الإباحية المزيفة من مواقعها على الويب الخاصة بها، بحجة أن هذا المحتوى ينتهك شروط الخدمة، ولكن لا يزال يتم مشاركة deepfakes من مجموعة الإباحية على منصات أقل انتشارا.

ومع ذلك، عندما يتعلق الأمر بخطاب سياسى ليس ذا طبيعة جنسية مسيئة، تصبح الخطوط ضبابية، ويواصل المنظمون والمشرعون التعامل مع هذه المشكلة.